Les fondamentaux - Chapitre 12 - Erreurs en imagerie médicale

L. Arrivé

Plan du chapitre

- Introduction

- Erreurs procédurales

- Erreurs de détection

- Erreurs d'interprétation

- Erreurs de communication

- Solutions d'amélioration

Introduction

La médecine n'est pas une science exacte. Il existe une intervention humaine qui implique la possibilité toujours présente d'une erreur qui peut avoir des conséquences plus ou moins graves. Évidemment, l'imagerie médicale n'échappe pas à cette règle. Dans la majorité des cas – et c'est une particularité propre à l'imagerie médicale –, l'erreur est vérifiable a posteriori puisqu'elle est attestée par un support physique qui peut être réanalysé a posteriori. Elle est en cela différente d'autres erreurs médicales moins faciles à vérifier a posteriori. Il est par exemple beaucoup plus difficile d'analyser l'imputabilité à une erreur médicale pour une complication chirurgicale.

En imagerie médicale, on peut résumer le processus de l'examen d'imagerie en plusieurs étapes :

- la demande d'examen par un médecin clinicien (le « demandeur ») qui doit ainsi poser une question ;

- la prescription de l'examen par un spécialiste d'imagerie, radiologue ou médecin nucléaire (le « prescripteur ») – il faut bien distinguer demande et prescription ;

- la réalisation de l'examen, le plus souvent par un membre du personnel non médical, le manipulateur en électroradiologie (sauf pour l'échographie, directement réalisée par un médecin en France ; en Australie, au Royaume-Uni, au Canada et aux États-Unis, les échographies sont réalisées par des membres du personnel non médical, des sonographers) ;

- la détection d'une anomalie potentiellement présente ;

- l'interprétation de cette anomalie ;

- la communication des résultats de l'examen (le prescripteur tente de répondre à la question du demandeur ; ce dernier interprète lui-même la réponse).

Chacune de ces étapes expose par nature aux risques d'erreurs.

Erreurs procédurales

Ce type d'erreurs concerne la réalisation de l'examen, qu'il s'agisse d'un examen dont l'indication n'est pas pertinente, d'un examen pour lequel la technique de réalisation a été insuffisante ou inappropriée (par exemple absence d'injection de produit de contraste alors que cette dernière était nécessaire), ou d'un examen pour lequel une erreur physique a été réalisée (erreur sur la région à examiner, épaule droite pour épaule gauche par exemple, voire erreur concernant l'identité du patient). L'identitovigilance constitue une des règles primordiales en imagerie médicale comme dans les autres domaines d'application médicale.

L'indication d'un examen d'imagerie médicale constitue un des piliers garants d'un résultat adéquat. Tout examen d'imagerie médicale est réalisé à la suite d'une demande d'examen. Celle-ci permet au radiologue ou au médecin nucléaire de choisir l'examen le plus adapté à la demande médicale et le protocole de l'examen à réaliser, mais également une interprétation des images en fonction des renseignements cliniques fournis par le médecin demandeur.

Pour optimiser sa prescription, le médecin peut s'appuyer sur des référentiels de recommandations de pratique clinique, réalisés par les différentes sociétés savantes (la Société française de radiologie [SFR], la

Société française de médecine nucléaire [SFMN]), ou l'association de plusieurs d'entre elles (on prendra le seul exemple du Guide du bon usage des examens d'imagerie médicale).

Ainsi, le choix du bon examen et de la bonne procédure de réalisation est fonction de ce qui est recherché. Par exemple, pour détecter un pneumopéritoine secondaire à la perforation d'un ulcère, il n'est pas raisonnable aujourd'hui de prescrire et de réaliser chez un adulte un cliché radiographique d'abdomen sans préparation dont on sait qu'il est très largement inférieur à la tomodensitométrie (TDM) qui permettra de visualiser un pneumopéritoine de petite abondance (voir chapitre 27). Il est vraisemblable que les applications de l'intelligence artificielle viendront optimiser les indications des examens d'imagerie médicale.

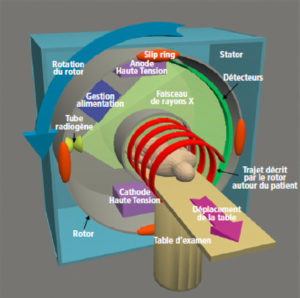

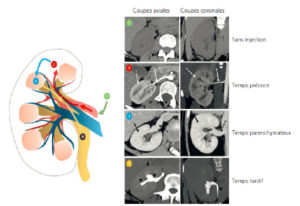

Toujours dans le cadre des erreurs procédurales – et il s'agit là de la responsabilité du médecin spécialiste d'imagerie –, il faut adapter la technique d'imagerie à la question clinique posée. Par exemple, si l'objectif est de chercher un pneumopéritoine, on peut parfaitement réaliser une TDM sans injection de produit de contraste. Au contraire, si l'on cherche une lésion d'un organe plein, il est généralement utile d'injecter un produit de contraste par voie veineuse pour sensibiliser la recherche des anomalies.

Erreurs de détection

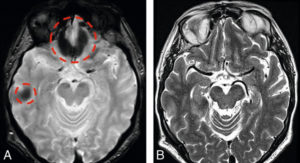

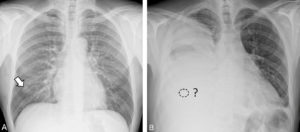

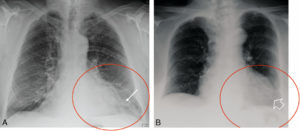

On considère ici comme erreur de détection, ou erreur de perception, une anomalie non détectée alors qu'elle était présente, mais non vue par l'observateur. L'erreur de détection est effectivement différente de l'erreur procédurale. Il s'agit donc ici d'une erreur visuelle, c'est-à-dire de la non-détection d'une anomalie visible a posteriori, erreur visuelle soumise aux lois de la vision humaine et de la perception. Ces erreurs doivent être évitées autant que possible, mais elles peuvent toucher même les médecins les plus expérimentés. Elles dépendent en partie du niveau de compétence et de la formation du médecin spécialiste d'imagerie, mais également de facteurs conjoncturels, comme le manque d'informations cliniques pertinentes, des conditions de travail mal adaptées et du degré de fatigue ou de stress de l'observateur.

Cependant, même dans les meilleures conditions, ces erreurs de détection sont inévitables de façon sporadique. Dans ce domaine encore, les applications de l'intelligence artificielle viendront vraisemblablement optimiser la détection des anomalies.

Erreurs d'interprétation

Il s'agit, dans ce cas, de l'interprétation inadéquate d'une anomalie supposée qui a été détectée. Elle peut entraîner un diagnostic faussement positif, quand par exemple une variante anatomique de la normale est considérée à tort comme une anomalie ou, a contrario, une interprétation faussement négative si une véritable anomalie, qui nécessiterait une prise en charge spécifique, est considérée comme une variante de la normale.

L'analyse rétrospective de larges séries d'erreurs en imagerie médicale a montré que les erreurs de détection sont beaucoup plus fréquentes que les erreurs d'interprétation ou cognitives avec un rapport d'environ 5 pour 1. Il est là encore possible que les applications de l'intelligence artificielle viennent optimiser l'interprétation des images. C'est probablement dans ce domaine de l'interprétation que l'influence de l'intelligence artificielle sera la moins rapide à s'installer.

Erreurs de communication

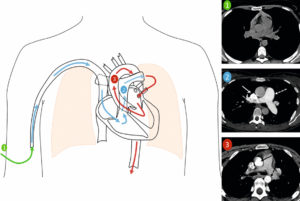

On peut classer ici l'ensemble des erreurs qui découlent d'une mauvaise communication entre le médecin spécialiste d'imagerie qui a interprété l'examen et le médecin demandeur. Il peut s'agir d'une absence physique d'information. C'est, par exemple, dans le cadre de la découverte d'une anomalie potentiellement grave mais non attendue, du non-respect du devoir d'information du médecin spécialiste d'imagerie au médecin demandeur. Par exemple, la découverte inattendue d'une embolie pulmonaire observée à l'occasion d'une TDM réalisée pour une autre raison implique, de la part du radiologue, l'obligation de s'assurer que l'information va directement et rapidement être communiquée au médecin demandeur. Plus généralement, les erreurs de communication peuvent découler de malentendus quant à la lecture d'un compte-rendu qui, par exemple, pourrait être jugé rassurant par le médecin demandeur, alors qu'il était simplement mal énoncé par le médecin spécialiste d'imagerie. Nous prendrons le seul exemple de l'interprétation du terme « compatible » qui peut être très différente (soit plutôt négatif, soit plutôt positif) selon les interlocuteurs.

Solutions d'amélioration

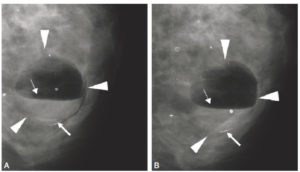

- La double lecture : interprétation systématique des examens par deux médecins de manière indépendante. Cette approche est appliquée dans le cadre des mammographies réalisées pour le dépistage du cancer du sein, afin de diminuer le risque d'interprétation faussement négative (voir chapitre 29). En revanche, cette double lecture expose au danger d'augmenter le risque d'interprétation faussement positive.

- La recherche d'un avis d'expert peut se faire dans le cadre d'un exercice en groupe, mais également aujourd'hui assez simplement dans le cadre des activités de télé-expertise propres à la téléradiologie qui fait appel au concours d'un spécialiste à distance consulté grâce aux techniques modernes de diffusion et de communication des informations.

- L'intervention des techniques d'intelligence artificielle va probablement améliorer les performances pour ce qui est de la juste indication des examens d'imagerie, de la détection des anomalies radiologiques et possiblement pour l'interprétation des images.

- Comme dans l'ensemble des exercices humains, il a été montré qu'une des techniques les plus efficaces pour réduire le risque d'erreur médicale était d'effectuer une analyse rétrospective des erreurs effectuées, afin de comprendre leurs mécanismes de survenue et de mettre en place des mesures de prévention pour éviter leur récidive.

|

Chapitre suivant |

|

Retour au sommaire |

Les fondamentaux - Chapitre 11 - Perception de l'image

J.-Y. Devaux , D. Galanaud et F. Brunotte

Plan du chapitre

- Introduction

- Étapes de la perception visuelle

- Particularités normales de la vision susceptibles d'interférer avec la perception des images

- Limitations de perception visuelle liées au vieillissement physiologique ou à des maladies de l'observateur

- Conséquences pour l'analyse des images

- Conclusion

Introduction

La perception visuelle est « le processus d'accès à la connaissance des objets et événements de l'environnement par l'extraction de l'information de la lumière émise ou réfléchie » [1]. La perception est donc une activité cognitive qui se distingue des phénomènes purement optiques. La présentation des images est susceptible d'en modifier la perception. La perception, combinée avec un choix judicieux de l'examen et avec la manière dont celui-ci est visualisé, permet d'arriver à un diagnostic d'imagerie. De nombreux écueils sont à identifier, liés à la manière dont le cerveau humain traite l'information visuelle.

Une image correspond à la localisation dans l'espace d'un signal physique. Les images examinées par le médecin sont soit constituées par de la lumière visible réfléchie (examen direct de la peau, endoscopie), soit transmises par l'élément biologique (microscopie), soit créées sur un écran vidéo, une image papier ou un film transparent. L'imagerie médicale décrite dans cet ouvrage correspond à la transformation en image visible des interactions d'un rayonnement avec un détecteur, rayons X et gamma en radiologie et médecine nucléaire respectivement, ondes radiofréquences en résonance magnétique et ondes ultrasonores en échographie. In fine, une image médicale est donc toujours transmise à l'observateur en lumière visible, condition pour qu'elle puisse constituer une image rétinienne, transmise au cerveau puis analysée et confrontée aux connaissances acquises par le médecin.

L'ordinateur est présent dans pratiquement tous les examens d'imagerie, à la fois pour le pilotage des acquisitions et leur visualisation sur les différents supports cités précédemment. Initialement analogiques, les images médicales sont donc désormais numérisées. Leur mode de présentation doit favoriser la capacité de l'œil humain à analyser ce qu'il perçoit. Les différentes modalités d'imagerie génèrent un volume croissant de données, représentant une information de plus en plus complexe, véritable défi cognitif pour le médecin chargé de l'analyse et de l'interprétation. La réalisation et l'interprétation correctes d'un examen vont nécessiter une série de décisions, conscientes et inconscientes, de la part du médecin imageur, qui vont interférer avec l'interprétation et le diagnostic final.

Les images soumises à l'interprétation médicale sont bidimensionnelles et représentent habituellement une matrice rectangulaire de pixels (voir chapitre 2).

Étapes de la perception visuelle

Les photons de lumière visible traversent les milieux transparents de l'œil dont le cristallin, responsable de l'accommodation, avant de former l'image rétinienne. Le spectre du rayonnement électromagnétique perceptible est très limité (au maximum de 380 à 780 nm). Le signal issu de la rétine, qui comporte à la fois des cellules sensibles aux couleurs (cônes) ou uniquement à l'intensité lumineuse (bâtonnets), subit un premier traitement de l'information au sein même de la rétine (par exemple détection de contours, détection de mouvements, analyse des couleurs). Il transite par les nerfs optiques, le chiasma et les corps géniculés latéraux, puis atteint le cortex visuel primaire dans la région occipitale. L'information visuelle est ensuite traitée dans deux régions distinctes : le réseau ventral (lobe temporal), impliqué essentiellement dans la reconnaissance de l'objet, la sensibilité aux détails et la mémorisation à long terme ; le réseau dorsal (lobe pariétal) traitant la relation de l'objet au sujet, le mouvement et la mémorisation à court terme.

Un élément essentiel du traitement de l'information, comme nous le verrons à plusieurs reprises, est la confrontation aux connaissances acquises préalablement par l'observateur qui va sans cesse confronter ce qu'il voit à ce qu'il connaît.

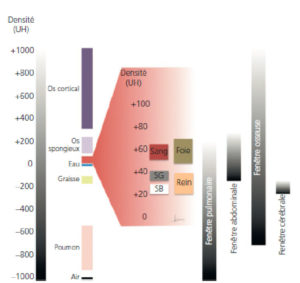

Perception du contraste et des couleurs

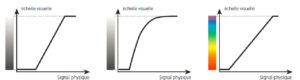

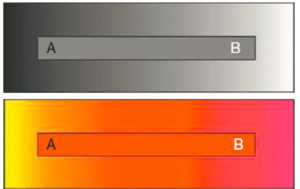

Les images issues des capteurs médicaux sont généralement représentées en nuances de gris. Leur représentation sur écran se fait le plus souvent sur 8 bits, soit 256 nuances de gris. Or, l'œil humain n'est capable de discerner en moyenne que 20 à 30 niveaux de gris différents et la discrimination des nuances est d'autant plus élevée qu'elles ne sont ni très sombres, ni très claires. Même l'examen d'imagerie le plus simple (une radiographie de thorax par exemple) dépasse largement nos capacités de perception et il faut développer des stratégies pour rendre visible de manière optimale le contraste des images. Il existe une transformation entre le signal mesuré (valeur numérique stockée dans un pixel) et sa représentation sur l'écran (figure 11.1). Cette représentation est généralement une fonction affine avec un minimum correspondant au noir et un maximum correspondant au blanc. Mais elle peut aussi être une fonction courbe plus complexe ou conduire à un affichage en échelle de couleurs.

Passage du signal physique mesuré à une échelle visuelle affichée.

Dessin : Emmanuel Durand.

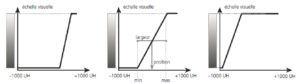

L'échelle de Hounsfield, utilisée pour la TDM, fait correspondre des valeurs allant de − 1000 UH (unités Hounsfield) à + 1000 UH à des niveaux de gris. On règle ainsi la largeur et la position de la fenêtre ou, ce qui revient au même, le minimum (correspondant au noir) et le maximum (au blanc) (figure 11.2).

Fenêtrage en TDM.

Dessin : Emmanuel Durand.

On obtient ainsi différentes « fenêtres » pour sélectionner les tissus explorés, voire accentuer leurs contrastes. De base, trois fenêtres sont utilisées : celle des « os », des « poumons » et des « tissus mous » (foie, cerveau, disques intervertébraux, etc.).

La plupart des autres modalités d'imagerie sont correctement présentées en 256 niveaux de gris, mais certains traitements d'image, en particulier ceux de l'imagerie fonctionnelle (IRM fonctionnelle, scintigraphie), les représentations volumiques et les associations bimodalités font appel à des échelles de couleurs.

Un des intérêts de la représentation colorée est qu'une couleur est identifiable de manière absolue avec une certaine précision (on distingue un jaune d'un rouge), alors que les niveaux de gris ne sont pas identifiables de manière absolue (figure 11.3). Les échelles colorées sont donc plus adaptées à la quantification alors que les échelles en niveaux de gris sont plus adaptées à une interprétation plus qualitative.

La partie A de la barre grise médiane semble plus claire que la partie B alors que le niveau de gris est le même tout le long de cette barre.

Il n'est donc pas possible d'identifier correctement un niveau de gris de manière absolue. On n'a pas la même impression avec les couleurs (le rouge est correctement identifié).

La représentation des couleurs peut se faire par synthèse « additive » (ajout de lumières de différentes longueurs d'onde) ; c'est le cas pour les moniteurs qui génèrent les couleurs au moyen de trois primaires (rouge, vert, bleu [RVB], RGB en anglais), correspondant grossièrement aux trois types de cônes de la rétine. Générant pourtant 16 millions de couleurs différentes, alors que l'œil humain n'en distinguerait, en moyenne, que quelques dizaines de milliers, les écrans de visualisation ne pourront jamais représenter toutes nos capacités de différenciation de nuances colorées, en particulier dans les verts ou les pourpres.

Lors d'une impression sur papier, il s'agit au contraire de synthèse soustractive : les encres ou la peinture absorbent certaines longueurs d'onde, qu'elles « soustraient » ainsi d'une lumière blanche polychromatique ; c'est la synthèse cyan, magenta, jaune (CMJ) (ou CMY en anglais). La représentation colorée est donc différente selon que le support est un écran ou un document imprimé, avec une difficulté de calibration pour représenter correctement les couleurs.

Résolution spatiale

La résolution des différentes modalités d'imagerie n'est pas identique (voir chapitre 2). Nettement inférieures au millimètre, les images radiographiques sont, en pratique, les plus résolues. Les images d'IRM et d'échographie sont de l'ordre du millimètre alors que les images de TEP et surtout celles de scintigraphie sont peu inférieures au demi-centimètre.

La résolution de l'image visualisée dépend de la taille du pixel. Devenus de grande dimension, les écrans actuels des services d'imagerie sont toujours très résolutifs. La résolution de l'écran peut être inutilement élevée si elle excède notablement la résolution physique de la technique. Mais elle peut être aussi trop faible et diminuer artificiellement les performances du système d'imagerie.

La résolution de l'œil humain habituellement appelée acuité visuelle est d'une minute d'angle (c'est-à-dire un soixantième de degré) pour un œil normal (acuité de 10/10) et correspond à la distance sur la rétine entre deux cônes adjacents.

Il faut donc s'assurer que l'angle sous lequel deux points à distinguer sur l'écran sont vus n'est pas inférieur à un angle d'une minute.

Particularités normales de la vision susceptibles d'interférer avec la perception des images

Contraste simultané

Une image en niveaux de gris est constituée de stimuli de luminance différente présentés simultanément. La perception visuelle va évidemment dépendre du pouvoir que possède le système visuel de discriminer ces stimuli. La psychophysique de la vision décrit des interactions entre ces plages voisines qui induisent la perception de contrastes qui n'existent pas sur l'image :

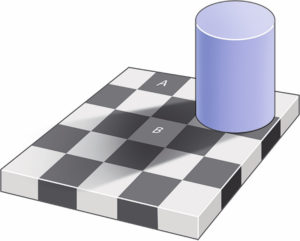

- échiquier d'Adelson (figure 11.4) ;

Les deux carrés A et B ont la même intensité.

Pourtant, le carré B apparaît plus clair car le cerveau « corrige » le cône d'ombre généré par le cylindre. Un tel phénomène peut se produire, en particulier en échographie (distorsion de la perception des contrastes liée au cône d'ombre derrière des calcifications). L'aspect inverse peut être dû au renforcement du signal derrière un volume purement liquidien.

Dessin : Cyrille Martinet

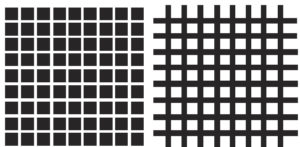

- grilles d'Hermann (figure 11.5) (illusion de présence de carrés gris) et bandes de Mach (renforcement de la perception du passage d'une nuance à une autre, augmentant le contraste) attribuables à l'organisation même de la rétine sous forme de champs récepteurs rétiniens ;

Grilles d'Hermann (1870).

Des carrés gris sont générés par illusion perceptive entre les cases noires ou inversement entre les cases blanches.

- dépendance de la perception du contraste de la fréquence spatiale dans l'image.

Illusions visuelles

De nombreux exemples démontrent que la perception d'une image n'est pas seulement l'enregistrement d'une image bidimensionnelle formée de luminance variable.

C'est le cas du contraste simultané que nous venons de détailler, mais c'est aussi celui de nombreux exemples montrant que l'évaluation des longueurs ou des formes géométriques dépend de leur environnement.

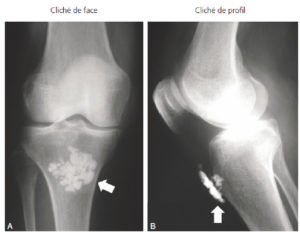

En fonction de leur environnement, deux formes géométriques de taille identique peuvent être perçues comme de tailles différentes, une droite peut apparaître courbe, un nodule identique peut paraître de taille différente en fonction du grossissement de l'image, etc.

Ces illusions sont à distinguer des artefacts : les premières correspondent à la mauvaise perception d'une information exacte, tandis que les artefacts sont la présence d'une information fausse sur l'image liée à des problèmes lors de la réalisation de l'examen. Les illusions d'optique peuvent entraîner des erreurs d'interprétation par mauvaise perception des images, en particulier en ce qui concerne la taille des objets ou leur intensité de signal.

Figures ambiguës

Une autre démonstration de la nature interprétative de la vision vient de l'existence d'images pouvant donner lieu à plusieurs perceptions différentes. C'est le cas de l'ambiguïté visage/vase (cas classique du « vase de Rubin »). Il faut noter que ces deux perceptions sont mutuellement exclusives et qu'elles sont en compétition dans l'interprétation que nous en faisons, ce qui exprime le fait que la perception implique la construction d'un modèle d'interprétation.

Remplissage perceptif

Lorsque plusieurs figures géométriques se cachent les unes derrière les autres, l'observateur a tendance à en reconstruire la partie cachée en fonction d'un modèle géométrique dont il fait plus ou moins inconsciemment l'hypothèse plus ou moins juste.

Objets « impossibles »

Certaines images bidimensionnelles formées de lignes très simples ne peuvent pas être décrites de manière synthétique. En effet, la forme ainsi construite ne peut pas être construite physiquement, ce qui en rend la perception impossible et ce qui prouve que la vision humaine comprend l'image rétinienne associée à une étape de modélisation qui repose sur une connaissance préalable des objets.

Limitations de perception visuelle liées au vieillissement physiologique ou à des maladies de l'observateur

Les anomalies pouvant toucher le système visuel sont très nombreuses. On peut citer (de manière non exhaustive !) : les troubles de la réfraction ou de la convergence, les dyschromatopsies7 qui touchent un homme sur dix mais pratiquement pas les femmes, les réductions du champ visuel, les rétinopathies, les atteintes des voies visuelles, du cortex visuel primaire ou du cortex associatif. La perception de l'image va ainsi varier considérablement en fonction des individus. Tous ces éléments doivent donc être pris en compte dans la visualisation des examens. L'analyse d'une série de 24 images/s sur un moniteur d'ordinateur sera plus spontanée pour un sujet jeune ayant une vision parfaite que pour un sujet plus âgé présentant une presbytie et un début de cataracte !

Conséquences pour l'analyse des images

Précautions dans la visualisation des images

Les modalités de visualisation de l'image peuvent exercer à l'insu de l'observateur un certain traitement de l'image. Ainsi, un examen imprimé sur un papier ou présenté sur un écran de mauvaise qualité sera plus difficilement interprétable et fera courir le risque de passer à côté de lésions de petite taille ou présentant un faible contraste.

La perception du contraste est également influencée par les conditions d'éclairage de l'environnement. L'interprétation requiert des tâches cognitives complexes qui seront influencées par la concentration du lecteur, mais aussi par ses connaissances acquises (voir chapitre 12). La lecture d'un examen dans une salle d'interprétation sombre, au calme, sur un moniteur de catégorie médicale de luminosité et de gamme colorimétrique bien calibrées n'aura pas grand-chose à voir avec la visualisation de ce même examen dans une salle bruyante, ensoleillée, sur un écran de petite taille non dédié et non calibré.

Compréhension des traitements d'images « involontaires »

Un certain nombre de manipulations d'images sont susceptibles, à l'insu du médecin, de modifier le contraste et la résolution des images. Parmi les situations correspondantes, citons un écran de résolution insuffisante, des images transmises après compression entraînant des pertes en résolution. L'utilisation de filtres destinés à améliorer la qualité visuelle de l'image (soit filtres lissants comme les filtres « gaussiens », soit filtres renforçant les bords) présente un certain danger de suppression d'une information pertinente ou de création d'artefacts et d'illusions d'optique. Ils sont donc à manier avec prudence.

Une lésion plus petite que la résolution de l'appareillage utilisé pourra ne pas être détectée à un stade précoce. En revanche, une lésion de très petite dimension sera identifiable si son métabolisme permet une imagerie fonctionnelle et génère une intensité élevée.

Adaptation de la présentation des images aux performances visuelles de l'imageur

La présentation des images doit être adaptée aux performances visuelles de l'imageur. L'exemple le plus convaincant est celui du fenêtrage que nous avons vu plus haut. L'œil étant incapable de percevoir l'ensemble des niveaux de luminance d'un examen en une seule image, il est nécessaire d'utiliser les 30 niveaux de gris que nous pouvons distinguer en plusieurs fois afin de bien détailler toute l'échelle des niveaux de gris. En matière de résolution, l'utilisation de zoom est souvent utile.

Importance de la confrontation à une base de connaissance solide de l'imageur

Il faut insister sur le fait que l'interprétation de l'image ne peut se faire de manière adéquate que par référence à la base de connaissance dont dispose l'imageur. Par exemple, un nodule pulmonaire ne sera pas vu de la même manière chez un jeune patient atteint d'une sarcoïdose que chez un sujet plus âgé et gros fumeur, ou bien une lésion osseuse qui peut avoir de multiples origines (fracture, infection, inflammation, arthrose, tumeur, etc.) ne pourra pas être analysée correctement si le type d'examen pratiqué ou les reconstructions d'images réalisées ne sont pas adaptés au mécanisme causal. Le mode de présentation de l'image est également important, comme nous l'avons vu précédemment.

Pour aller plus loin

« Have you seen the dancing gorilla ? » : il s'agit d'une expérience célèbre réalisée par Daniel Simons et Christopher Chabris des départements de radiologie et de psychologie de la Harvard Medical School. Une courte vidéo est projetée, durant laquelle deux groupes de joueurs, certains habillés en blanc d'autres en noir, se font des passes de basket. Il est demandé aux participants de compter le nombre de fois où les joueurs habillés en blanc se passent la balle. Dans le même temps, un septième personnage, déguisé en gorille, traverse la scène en effectuant quelques pas de danse. La moitié des participants ne remarque pas la présence du gorille.

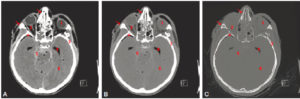

Ce phénomène est appelé cécité d'inattention, c'est-à-dire le fait de ne pas percevoir un stimulus visuel parfaitement visible car l'attention est captée par une autre tâche. L'implication en imagerie médicale est évidente et a été vérifiée par une équipe de radiologues de la même université. Si on recherche une lésion particulière (par exemple une tumeur), on peut ne pas remarquer une autre pathologie, pourtant bien visible (par exemple accident vasculaire cérébral, embolie pulmonaire, etc.).

Conclusion

Recueillir, traiter et interpréter des images : ce sont les actions à la base de nombreux diagnostics médicaux. Les caractéristiques du contraste et de la résolution de ces images doivent être adaptées de manière optimale, à la fois selon le procédé d'acquisition utilisé et selon les capacités de perception visuelle des imageurs concernés. Les possibilités de traitement de l'image par les ordinateurs modernes sont très performantes, mais leurs procédés d'affichage doivent être régulièrement contrôlés afin de maintenir la sûreté de leur usage dans l'intérêt des patients. Parallèlement, les imageurs doivent toujours être conscients des limites de la vision humaine lors de leur interprétation des images.

Référence

[1] Palmer SE. Vision Science. Photons to phenomenology. Cambridge MA : The MIT Press Third printing ; 2002.

|

Chapitre suivant |

|

Retour au sommaire |

Les fondamentaux - Chapitre 10 - Traitement de l'image reconstruite

A. Blum

Plan du chapitre

- Introduction

- Reconstructions d'acquisitions volumiques

- Recalage, soustraction, fusion

- Réalité augmentée

- Conclusion

Objectif

- Connaître les principales modalités de traitement de l'image.

Introduction

En imagerie médicale, la formation de l'image résulte de la mesure physique des interactions entre un processus physique (rayons X, ultrasons, ondes radiofréquences, etc.) et les tissus biologiques. Ces variations d'interactions sont captées, analysées et transformées en signaux. Ces signaux sont alors traduits en une ou plusieurs images immédiatement interprétables.

L'image médicale est numérique. Qu'elle représente une projection ou une coupe, elle se divise en unités élémentaires appelés pixels (picture element). Ces pixels possèdent une information topographique et une valeur de signal représentant les interactions avec les tissus biologiques.

Lorsque l'image représente une coupe, le pixel correspond à une unité de volume élémentaire appelée voxel (volume element) (voir chapitre 2). On dispose des informations concernant sa position au sein de la coupe, sa position au sein du volume, l'épaisseur de la coupe (identique à l'épaisseur du voxel) et sa valeur de signal. L'accès aux informations affectées à chaque pixel et à chaque voxel fournit de multiples possibilités de traitement de l'image pour les modalités d'acquisition par coupes (tomodensitométrie [TDM], imagerie par résonance magnétique [IRM] et échographie). Ce chapitre aborde quelques-unes des nombreuses opérations de traitement de l'image :

- reconstructions d'acquisitions volumiques ;

- segmentation qui vise à délimiter les contours d'organes et les sélectionner ;

- recalage, permettant soustraction ou fusion.

Reconstructions d'acquisitions volumiques

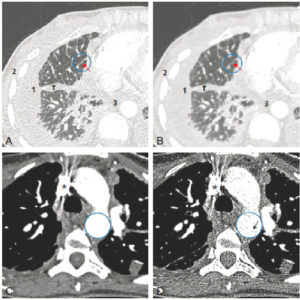

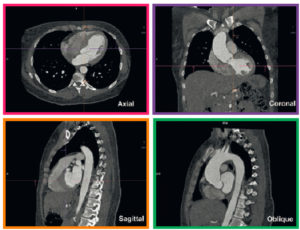

Reconstructions multiplanaires (MPR)

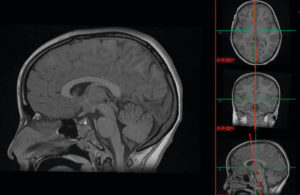

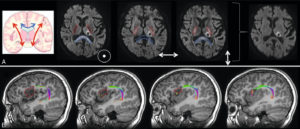

L'empilement des coupes permet de reconstituer le volume et de produire des coupes dans tous les plans de l'espace (axial, coronal, sagittal, oblique) (figure 10.1). Ces coupes sont appelées reconstructions multiplanaires (multiplanar reconstruction [MPR]). Leur qualité est d'autant meilleure que la résolution spatiale longitudinale (axe perpendiculaire au plan de coupe) est élevée, c'est-à-dire que l'épaisseur du voxel et la distance séparant les coupes sont faibles. Un volume isotrope (résolution identique dans les trois axes ou voxel cubique) procure les meilleurs résultats. En TDM, le chevauchement des coupes améliore la résolution spatiale longitudinale.

MPR : le volume obtenu à partir d'une acquisition sur le crâne en IRM en pondération T1 permet d'analyser les structures cérébrales dans les trois plans de l'espace.

Reconstructions projectives

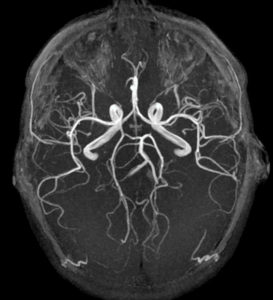

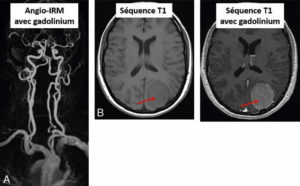

Cette technique permet de projeter sur un même plan, selon une direction choisie, les voxels d'intensité maximale (maximal intensity projection [MIP]) (figure 10.2) ou les voxels d'intensité minimale (minimal intensity projection [MinIP]) (figure 10.3). La technique MIP est utile pour étudier les structures vasculaires. La technique MinIP est utile pour étudier les structures contenant de l'air, comme les bronches, ou pour de fines structures au sein de l'os en haute résolution.

Projection en mode MIP (maximum intensity projection) dans le plan axial à partir d'une séquence d'angio-IRM sans injection de produit de contraste (technique de temps de vol ou time of flight) montrant les artères du cercle artériel du cerveau.

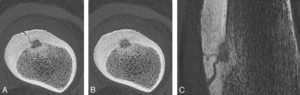

Projection MinIP (minimum intensity projection).

Ostéome ostéoïde de 8 mm de hauteur du fémur gauche chez une femme de 31 ans exploré en super haute résolution (coupes de 0,25 mm d'épaisseur, matrice 1024 × 1024). A, B. Coupes axiales. C. Image MinIP dans le plan sagittal. Noter la qualité de l'analyse de la réaction corticopériostée et la démonstration d'une multitude de vaisseaux alimentant le nidus. Noter également qu'une image MinIP de l'os n'a d'intérêt qu'avec des voxels particulièrement petits.

Source : Blum A, Teixeira P. Scanner et IRM ostéo-articulaires en pratique. Paris : Elsevier Masson ; 2022.

Segmentation

La délimitation d'une zone (par exemple un organe ou une tumeur) dans une image permet de mieux visualiser la structure, d'en quantifier le signal ou d'en mesurer le volume. Une telle zone est appelée région d'intérêt (region of interest [ROI]) et sa délimitation est appelée segmentation. Celle-ci peut se faire manuellement, mais l'utilisation d'algorithmes automatiques ou semi-automatiques de segmentation d'organes et de lésions permet d'augmenter la précision, la fiabilité et la répétabilité de leur représentation ainsi que la mesure de leur volume. Différentes techniques de segmentation sont utilisées ; la plus simple est de déterminer si un pixel appartient ou non à la région d'intérêt en fonction de la valeur du signal par simple seuillage. D'autres techniques plus complexes prennent en compte la taille, la régularité du contour, les caractéristiques des pixels voisins, la connectivité (le fait que la région soit d'un seul tenant).

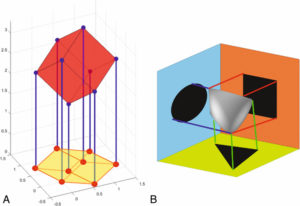

Rendu de volume et illumination globale

Les images 3D ont pour objectif d'améliorer l'analyse topographique des structures, en offrant une vue globale de la région explorée. Les images 3D font appel à une technique dite de volume rendering technique (VRT). Elles sont réalisées après un seuillage des voxels afin de sélectionner les structures d'intérêt. Des pseudo-couleurs et un certain degré de transparence sont affectés à chaque voxel en fonction de leur valeur de signal. Certains logiciels permettent une mesure des distances ou des angles tridimensionnels.

L'obtention d'une vue 3D sur un plan est obtenue en appliquant deux principes :

- le principe des surfaces cachées : une structure proche de l'œil de l'observateur cache un objet plus distant ;

- l'ombrage : en supposant que l'œil de l'observateur soit la source lumineuse, les objets proches de son œil ou qui lui font face sont plus lumineux que ceux qui sont lointains ou dans l'axe du faisceau lumineux (figure 10.4A).

![Figure 10.4 Comparaison des techniques de rendu de volume (volume rendering technique [VRT]) et du global illumination dans un cas de plaie par balle. A. VRT. B. Global illumination reconstruction. Noter la meilleure visibilité des lésions grâce à l'imagerie photoréaliste (B). Source: Blum A, Gillet R, Rauch A, et al. 3D reconstructions, 4D imaging and postprocessing with CT in musculoskeletal disorders: Past, present and future. Diagn Interv Imaging 2020 ; 101(11) : 693-705.](https://www.cnp-mn.fr/wp-content/uploads/2023/01/Les-fondamentaux-10.4-300x150.jpg)

Comparaison des techniques de rendu de volume (volume rendering technique [VRT]) et du global illumination dans un cas de plaie par balle.

A. VRT. B. Global illumination reconstruction. Noter la meilleure visibilité des lésions grâce à l'imagerie photoréaliste (B).

Source: Blum A, Gillet R, Rauch A, et al. 3D reconstructions, 4D imaging and postprocessing with CT in musculoskeletal disorders: Past, present and future. Diagn Interv Imaging 2020 ; 101(11) : 693-705.

La technique d'illumination globale, plus souvent appelée global illumination (imagerie photoréaliste), remplace progressivement la VRT grâce à une représentation plus réaliste de l'éclairage des objets (figures 10.4B et 10.5B) et à la possibilité d'utiliser des images avec une forte résolution spatiale, ce qui permet d'améliorer la détection et la perception des lésions (figures 10.6 et 10.7).

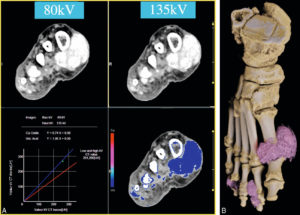

TDM en double-énergie du pied droit chez un patient suivi pour une goutte.

A. Caractérisation du tophus à partir d'une acquisition à basse énergie (80 kV) et haute énergie (135 kV) et la détermination de sa composition sur chacune de ces acquisitions. B. Global illumination fournissant une cartographie des multiples tophus de l'avant-pied droit.

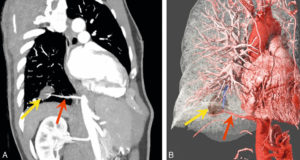

Séquestration pulmonaire intralobaire chez un homme de 59 ans.

MPR oblique (A) et global illumination (B) après segmentation des vaisseaux et du poumon. La séquestration pulmonaire est une malformation congénitale du poumon où une partie du tissu pulmonaire n'est connecté ni à l'arbre bronchique, ni à la circulation vasculaire pulmonaire. Noter la séquestration (flèche jaune) et son artère nourricière qui naît de l'aorte thoracique descendante (flèche rouge).

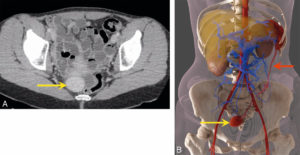

Ectopie splénique.

Coupe axiale en TDM (A) et global illumination après segmentation des vaisseaux et des différents organes (B). Noter la rate accessoire (flèche jaune) et son long pédicule vasculaire (flèche rouge) dont la topographie contribue au diagnostic. L'ectopie splénique ou « rate baladeuse » se définit comme la migration de la rate dans n'importe quel quadrant de l'abdomen. Elle peut être asymptomatique, de découverte fortuite ou responsable de douleurs abdominales en cas d'épisodes de torsion ou d'infarctus splénique.

Recalage, soustraction, fusion

L'appariement et le recalage d'images prennent une place croissante dans l'analyse des données car ces opérations fournissent une analyse simultanée de deux acquisitions différentes d'un même patient :

- soit d'une même modalité à des temps différents ; par exemple TDM sans puis avec injection ; suivi de la réponse au traitement par chimiothérapie d'une tumeur au cours du temps ;

- soit de deux modalités différentes ; par exemple : TDM et TEP pour superposer l'information anatomique et fonctionnelle ; TDM et IRM.

Les opérations de recalage sont le préalable à la fusion ou à la soustraction des images.

Recalage

Pour pouvoir efficacement comparer deux images, les structures étudiées doivent avoir la même position. Or, lorsque les images ont été acquises sur deux appareils différents ou lorsque le patient a bougé entre deux acquisitions sur un même appareil, la mise en correspondance des images nécessite une opération appelée recalage. Les tailles du champ de vue et des pixels n'étant pas nécessairement les mêmes pour les deux images, la première étape du recalage consiste en un reformatage des images dans une base commune. La seconde étape repose sur des transformations rigides ou élastiques des objets de l'image afin de les faire correspondre :

- transformations rigides, lorsque l'objet ne s'est pas déformé mais a simplement bougé, qui consistent en de simples translations et rotations ;

- transformations élastiques, lorsque l'objet se déforme comme lors des mouvements respiratoires ou des battements cardiaques. Ces opérations sont plus complexes et altèrent potentiellement les mesures de signal.

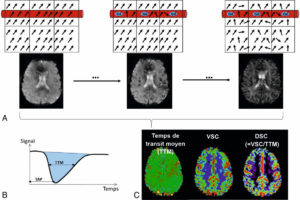

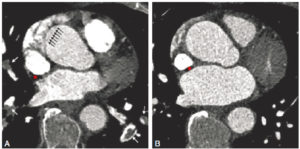

Soustraction

La soustraction est utilisée depuis longtemps en angiographie numérisée. Une première acquisition est réalisée sans injection de produit de contraste, suivie d'une deuxième acquisition avec injection. Les deux séries sont ensuite soustraitées numériquement ; la différence correspond alors aux zones où se localise le produit de contraste, notamment dans les vaisseaux et les tissus hypervascularisés qui sont ainsi mieux visualisés. Cette technique est désormais élargie aux images en coupe ; elle est notamment appliquée en TDM et en IRM de perfusion pour l'analyse de la cinétique de rehaussement d'une tumeur.

Fusion

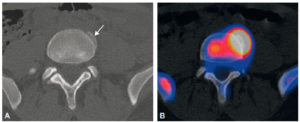

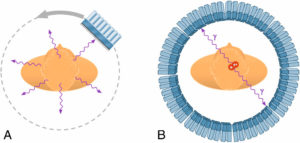

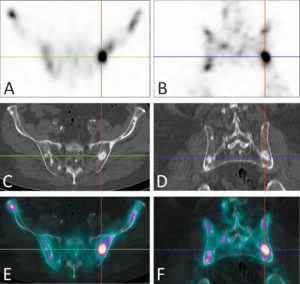

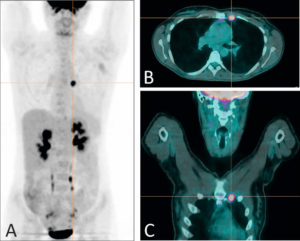

La fusion met en concordance dans le même espace numérique des images de même nature ou de nature différente. En médecine nucléaire (tomoscintigraphie, TEP-TDM, TEP-IRM) comme en IRM fonctionnelle, elle combine des informations fonctionnelles et morphologiques pour améliorer la valeur diagnostique des examens (figure 10.8).

Tomoscintigraphie avec TDM (A) et image de fusion d'une tomoscintigraphie osseuse et TDM (B) d'un syndesmophyte dans le cadre d'une spondylarthrite ankylosante.

La TDM montre l'anomalie morphologique (flèche). L'image de fusion montre l'activité ostéoblastique qui lui est associée.

Réalité augmentée

L'imagerie médicale est essentielle pour la planification préopératoire, mais elle peut également être utilisée pendant l'intervention pour en améliorer la précision et la sécurité. Le principe de la réalité augmentée consiste à superposer au monde réel et en temps réel des objets issus d'images médicales (TDM, IRM, etc.). Cette technique fait appel aux principes de segmentation, de recalage et de fusion de données multimodales. La réalité augmentée est une des processus nécessaires à la chirurgie assistée par ordinateur (CAO).

Conclusion

Les performances accrues de l'informatique permettent de faire appel à des techniques de reconstruction d'image plus nombreuses et plus performantes. Elles autorisent également des opérations combinées des données acquises et la manipulation en temps réel des différentes informations.

Essentiel à retenir

- Les modalités d'imagerie en coupe permettent de produire des volumes numériques, auxquels de multiples traitements peuvent être appliqués : reconstructions dans tous les plans de l'espace, représentations tridimensionnelles, seuillage, segmentation, recalage et fusion.

|

Chapitre suivant |

|

Retour au sommaire |

Les fondamentaux - Chapitre 9 - Reconstruction tomographique

F. Ben-Bouallègue , E. Durand et D. Mariano-Goulart

Plan du chapitre

- Introduction

- Notion de projection

- En tomoscintigraphie

- En tomodensitométrie

- Problème direct – problème inverse

- Résolution du problème inverse en résolvant le système d'équations

- Rétroprojection

Objectifs

L'imagerie médicale repose schématiquement sur l'acquisition d'un signal physique, sur l'optimisation de ce signal (filtrages), sur sa mise en forme pour en faciliter l'utilisation médicale (reconstructions), puis sur son analyse (extraction d'éléments diagnostiques) qui fera l'objet du chapitre 10. Parmi les divers types de reconstructions possibles, la reconstruction tomographique joue un rôle central en tomodensitométrie (TDM), en imagerie par résonance magnétique (IRM) et en tomoscintigraphie d'émission. Elle fait l'objet de ce chapitre qui explique en quoi la reconstruction d'images tomographiques relève d'un problème linéaire mal conditionné et sur quels principes fonctionnent les algorithmes de rétroprojection filtrée et les techniques itératives de reconstruction. Il exclut tout formalisme mathématique, mais pourra servir d'introduction à l'approfondissement plus complet [1], mais aussi plus scientifique de la tomographie médicale.

Introduction

Avec W. Röntgen et H. Becquerel, puis la famille Curie, le XIXe siècle finissant avait vu éclore une physique des rayonnements ionisants qui permettait pour la première fois de visualiser les organes internes d'un patient de façon non invasive. Le développement de l'imagerie radiologique qui suivit très vite, puis de l'imagerie scintigraphique resta cependant longtemps cantonné à la production d'images de projections où les signaux issus des divers plans perpendiculaires au rayonnement incident se superposaient sur un plan unique, rendant complexe l'interprétation médicale. Les solutions théoriques qui permirent de résoudre cette difficulté et de disposer d'une imagerie volumique ou reconstruite en coupes existaient pourtant dès le début du XXe siècle, avec les travaux des mathématiciens J. Radon en 1917 et S. Kaczmarz en 1937.

Mais il fallut attendre l'intervention d'un ingénieur talentueux, G.N. Hounsfield, au tout début des années 1970, le développement des calculateurs numériques qui accompagna la conquête de la Lune, puis le parrainage financier d'une société d'édition musicale qui bénéficiait dans les années 1960 du succès phénoménal de quatre chanteurs à la mode venus de Liverpool pour que naisse la tomographie médicale et que les premiers scanners prennent peu à peu la place qu'on leur connaît de nos jours dans le diagnostic médical.

Notion de projection

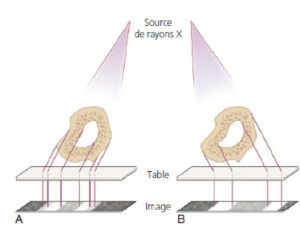

D'une manière assez générale, on cherche à obtenir des images en trois dimensions (3D) mais les acquisitions se font généralement en deux dimensions (2D). C'est le cas aussi pour la vision : nous percevons sur notre rétine (2D) l'image 2D d'un monde en 3D ; on parle de projection (figure 9.1A). Cela s'applique aussi à la plupart des techniques d'imagerie médicale : TDM, tomoscintigraphie, TEP et, dans certains cas, à l'IRM3.

Projection.

A. Une figure 3D est projetée sur un plan et transformée en figure 2D, comme une ombre projetée. B. Projeter selon différentes directions conduit à différentes projections à partir d'un même objet.

Dessin : Emmanuel Durand.

Le fait de projeter entraîne une perte d'information : à partir de l'ombre d'un objet, on ne peut pas déterminer l'objet lui-même. En revanche, la combinaison de différentes projections permet d'avoir une meilleure idée de l'objet de départ (figure 9.1B). C'est le principe général de la reconstruction tomographique, objet de ce chapitre.

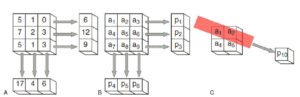

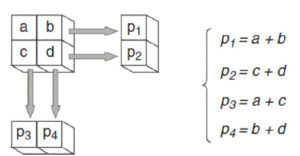

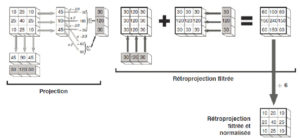

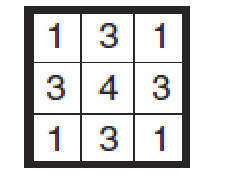

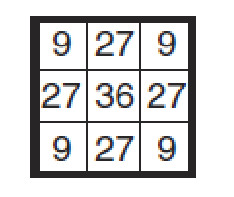

Du point de vue informatique, on considère qu'une image est composée d'une matrice de voxels, considérés comme homogènes et caractérisés chacun par la valeur du signal physique qu'il contient. En pratique, la projection selon un axe vertical ou horizontal consiste simplement à faire la somme de toutes les valeurs le long d'une ligne ou d'une colonne (figure 9.2A). Bien entendu, une projection selon une direction oblique est plus complexe, mais le principe est le même. Projeter une image 3D sur un plan 2D est difficile à représenter et plus complexe à écrire en équations. Dans tout ce qui suit, nous partirons donc d'une image en 2D pour la projeter sur une ligne en 1D, ce qui est plus simple à la fois à représenter et à modéliser en équations. Le principe reste strictement le même pour passer du 3D au 2D.

A. Projection d'une matrice de voxels en lignes ou en colonnes. B. Si l'on représente les nombres de la matrice de manière symbolique par ai,j, on peut facilement calculer les valeurs des projections, par exemple : p1 = a1 + a2 + a3 ou p4 = a1 + a4 + a7. C. Le calcul des projections obliques est plus compliqué, faisant appel à des sinus et cosinus, mais se fait sur le même principe, par exemple ici p10 ≈ 0,8 × a1 + 0,9 × a2 + 0,15 × a5.

Dessin : Emmanuel Durand.

En tomoscintigraphie

En tomoscintigraphie, lorsqu'on utilise un collimateur parallèle, le signal de chaque voxel correspond au nombre de photons gamma résultant de l'activité dans ce voxel, lui-même proportionnel à la concentration de radioactivité. Le nombre total de photons détectés sur un élément de détection de la gamma-caméra correspond exactement à la somme des signaux des voxels le long d'une perpendiculaire au détecteur4 (figure 9.3 et voir figure 9.2B). L'image captée par le détecteur (2D) est donc bien une projection de l'activité de l'ensemble des voxels (3D). Il en va de même en TEP avec la détection en coïncidence.

Projections et reconstructions en tomodensitométrie et en tomoscintigraphie.

Dessin : Denis Mariano-Goulart.

D'une manière générale, on peut exprimer la valeur de chaque projection comme :

pk = sum from {i} rk,i × ai (1)

où ai désigne le signal du voxel i, pk la projection k et les coefficients rk,i la proportion de volume du pixel i qui se projette effectivement dans la projection k. Dans l'exemple de la figure 9.2B, on aurait par exemple r1,1 = 1 ; r1,4 = 0 et r2,4 = 1. En faisant tourner la gamma-caméra autour du patient, on peut ainsi obtenir de très nombreuses projections sous des angles différents. En TEP, la détection en coïncidence permet d'obtenir simultanément des projections dans toutes les directions visibles du détecteur.

En tomodensitométrie

En TDM, on envoie un faisceau de rayons X d'intensité I0 ; après avoir traversé le patient, ce faisceau ressort de manière atténuée avec une intensité Ii. La loi générale d'atténuation est :

Ii = I0 × e-μL (2)

après la traversée d'une longueur L d'un milieu de coefficient d'atténuation μ (voir figure 9.3).

Si l'on considère la traversée des 3 voxels numérotés 1, 2 et 3 comme sur la figure 9.2B, en désignant par d la largeur du voxel, l'atténuation de la première ligne de projection sera donnée par :

I1 = I0 × e-µ1d × e-µ2d × e-µ3d = I0 × e-( µ1 + µ2 + µ3)d (3)

L'opération n'est donc pas une simple somme, comme dans la tomoscintigraphie. Cependant, en transformant l'équation 3, on aboutit facilement à :

ln(I0 /I1) / d = µ1 + µ2 + µ3 (4)

On est donc ramené exactement au problème précédent de la tomoscintigraphie où chaque projection est la somme des signaux des voxels. Dans le cas de la TDM, le signal d'un voxel correspond au coefficient d'atténuation. Comme en tomoscintigraphie, on fait tourner le tube et le détecteur autour du patient pour acquérir de très nombreuses projections sous différents angles.

Problème direct – problème inverse

L'acquisition de l'image consiste à mesurer l'ensemble des projections pk. La reconstruction de l'image consiste à en déduire l'ensemble des signaux des voxels ai qui sont des inconnues. Modéliser l'acquisition revient à déterminer l'ensemble des coefficients rk,i qui déterminent les projections. En gros, cela revient à être capable de modéliser l'acquisition des projections, c'est-à-dire, connaissant les valeurs des voxels ai, à être capable de prédire les projections pk. On appelle cela le problème direct. C'est finalement assez simple si l'on connaît la géométrie de l'acquisition.

Dans la « vie réelle », on ne connaît pas les valeurs des voxels ; c'est même justement ce qu'on cherche à déterminer à partir des projections qu'on a pu mesurer. On appelle cela un problème inverse. On dispose donc de données connues, les projections pk, d'un système d'équations linéaires du style de l'équation 1 : pk = sum ( rk,i × ai). Il suffit donc en théorie de trouver les inconnues ai en résolvant ce système.

Résolution du problème inverse en résolvant le système d'équations

Dans le cas simplifié représenté par la figure 9.4, on a un système de 4 équations à 4 inconnues (a,b,c et d).

Cas simplifié.

Dessin : Emmanuel Durand.

Il est donc en théorie relativement facile de le résoudre, en particulier si l'on dispose de calculateurs électroniques. En pratique, si l'on considère une image 3D en matrice 256 × 256 × 256, on a donc 16 777 216 inconnues ; il faut un nombre d'équations au moins égal pour pouvoir le résoudre. Cette résolution mathématique théorique nécessite alors beaucoup de calculs élémentaires et est mise en défaut par une propriété propre à la plupart des grands systèmes d'équations linéaires.

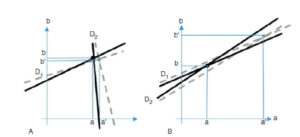

Pour l'illustrer, simplifions encore notre exemple en nous attachant à reconstruire une image constituée de deux pixels (a,b) seulement, au moyens de deux projections p1 et p2.

Les deux équations de projection s'écrivent :

D1 : p1 = r11 · a + r12 · b

D2 : p2 = r11 · a + r12 · b

Dans un graphe où l'on place en abscisse les valeurs possibles de a et en ordonnée celles de b, ces deux équations sont celles de deux droites D1 et D2 dont l'intersection est la solution (a,b) du système, donc la coupe recherchée. Si ces deux équations sont très différentes l'une de l'autre (figure 9.5A), une petite erreur sur la modélisation des coefficients rij ou sur la mesure des projections pi par l'appareil d'imagerie conduit à une erreur minime (a′,b′) sur l'estimation de l'intersection de ces deux droites, donc de l'image recherchée. En revanche, si les deux équations ont des coefficients proches, la moindre erreur sur le modèle (rij) ou sur les mesures de projections (pi) donnera un résultat complètement erroné pour la coupe, avec une solution (a′,b′) très éloignée de la vérité (figure 9.5B). En tomographie, où l'on acquiert beaucoup de projections très proches les unes des autres, cette seconde situation est malheureusement la règle.

A, B. Les droites grises en pointillées représentent des projections légèrement différentes des projections exactes, en traits pleins noirs.

On constate que si deux projections sont proches, une erreur importante sur l'estimation de l'image en coupe (a, b) peut subvenir si ces projections sont faiblement bruitées.

Dessin : Denis Mariano-Goulart.

Pour cette raison, la technique qui semble a priori la plus simple, résoudre un système d'équations par un algorithme standard (déterminant, pivot de Gauss, etc.), ne peut pas être utilisée. Cela va donc nécessiter l'utilisation d'algorithmes plus complexes que ceux classiquement utilisés en algèbre.

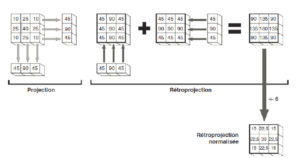

Rétroprojection

Pour comprendre comment se fait la reconstruction, nous avons besoin de décrire un nouvel opérateur appelé « rétroprojection ». Mathématiquement, la rétroprojection consiste à sommer, au sein d'un pixel image i, chacune des projections k auquel il participe, pondérées par le coefficient rk,i.

Projection : pk = sum from {i} rk,i × ai (5)

Rétroprojection : bi = sum from {k} <?> rk,i × pk (5)

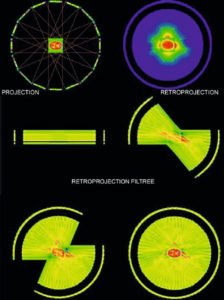

Concrètement, il s'agit de « propager » la valeur projetée, dans la direction de la projection, sur tous les pixels concernés (figure 9.6), et de sommer le résultat pour toutes les projections. On voit ici que l'image de rétroprojection (normalisée) ne correspond pas vraiment à l'image de départ : la rétroprojection n'est donc pas l'opération inverse de la projection. Cependant, on constate des similitudes ; par exemple, le voxel central a la valeur la plus élevée sur les deux images ; l'angle supérieur gauche a la plus faible valeur dans les deux cas.

Principe de la rétroprojection.

On prend les projections verticales et on les rétroprojette verticalement en « propageant » chaque valeur sur toute la colonne ; on fait de même avec les projections horizontales, puis on ajoute l'ensemble des rétroprojections. On peut ensuite normaliser la rétroprojection en divisant par le nombre de rétroprojections (6 ici). N.B. : pour modéliser correctement une image de 3 × 3 = 9 pixels, il faudrait au moins 9 projections. On en a pris moins ici par souci de simplification.

Dessin : Emmanuel Durand.

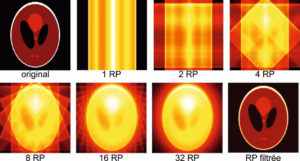

L'application de cet opérateur de rétroprojection pour la reconstruction des images à partir de projections produit des images qui ressemblent à l'image originale, sans lui être identique (figure 9.7). Cela illustre encore le fait que la rétroprojection n'est pas l'opérateur inverse de la projection.

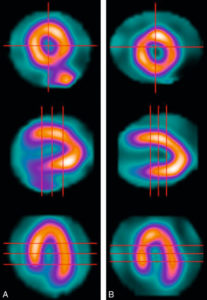

Rétroprojection.

À partir d'une image originale (simplifiée) dont on a déterminé les projections dans diverses directions, on construit les rétroprojections avec un nombre de projections allant de 1 à 32 ; on voit alors se dessiner progressivement une représentation imparfaite de l'image originale. Seule une opération de filtrage permettra de retrouver une représentation fidèle de l'image originale.

Dessin : Emmanuel Durand.

Rétroprojection filtrée

La simple opération de rétroprojection ne permet donc pas d'obtenir une image fidèle ; on voit en effet, sur les images reconstruites, des artefacts en étoile ou en halo correspondant aux traînées de rétroprojection (figure 9.8 et voir figure 9.7). On constate ainsi sur la figure 9.6 que le contraste entre le centre et les bords est plus faible sur l'image reconstruite par rétroprojection que sur l'image originale. Avant de rétroprojeter, il faut donc accentuer le contraste pour compenser cet effet. Ce filtrage, appelé « filtre rampe » et fondé sur des bases mathématiques solides, peut s'illustrer de la manière suivante : on va renforcer le contraste en changeant la valeur rétroprojetée ; au lieu de prendre la valeur obtenue par projection (voir figure 9.6), on prendra le double de cette valeur diminuée des deux tiers des valeurs des projections adjacentes.

Illustration des opérations de projection, de rétroprojection et de rétroprojection filtrée dans le cas d'une tomoscintigraphie cérébrale.

Dessin : Denis Mariano-Goulart.

Lorsqu'on multiplie le nombre de rétroprojections filtrées, on obtient une image fidèle à l'objet original (figure 9.9).

Rétroprojection filtrée.

Par rapport à la rétroprojection simple, au lieu d'utiliser la valeur de projection, on prend le double et on retranche les deux tiers de chaque projection voisine. Dans cet exemple simple, la reconstruction permet de trouver l'objet qu'on a projeté. En pratique, il faut généralement prendre davantage de projections pour obtenir une reconstruction correcte (ici, on n'a que 2 projections de 3 pixels, soit 6 valeurs numériques ; dans le cas général, il en faut davantage pour reconstruire une image de 3 × 3 = 9 pixels).

Dessin : Emmanuel Durand.

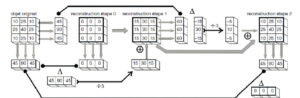

Reconstruction itérative

L'algorithme de rétroprojection filtrée ne nécessite pas de calculateurs électroniques puissants et a été universellement utilisé en TDM et en tomoscintigraphie jusqu'à la fin du XXe siècle. Dans les années 1970, exploitant des travaux initialement dus au mathématicien polonais S. Kaczmarz, une nouvelle famille d'algorithmes dits itératifs (ou algébriques) s'est peu à peu imposée en imagerie scintigraphique, puis en radiologie. Son développement, rendu possible par la puissance de calcul des ordinateurs modernes, a permis de réduire l'irradiation des patients en radiologie tout en se contentant, en particulier en TEP, de données de projections parfois incomplètes (ce que l'algorithme de rétroprojection filtrée ne permet pas). Ces techniques permettent en outre de mieux prendre en compte le mauvais conditionnement du problème tomographique (régularisation) et de mieux corriger certains artefacts inhérents aux acquisitions des projections (auto-atténuation en médecine nucléaire). Cette famille d'algorithmes a en commun de déterminer la coupe compatible avec les projections effectivement acquises en évaluant un écart entre celles-ci et des projections calculées à partir d'une estimation de la solution, puis en corrigeant l'estimation de la coupe au moyen de l'écart constaté.

En d'autres termes, on est capable d'acquérir des projections du corps humain en utilisant un appareil d'imagerie (TDM ou gamma-caméra). Comme nous l'avons vu, l'opération inverse n'est pas simple. En revanche, si l'on dispose d'une image informatique de l'objet, il est très simple d'en faire des projections au moyen d'un programme informatique. On peut alors comparer les projections de l'objet et les projections de son image. Le principe des techniques itératives est donc de trouver, par approximations successives, l'image qui donnera les mêmes projections que celles obtenues lors de l'acquisition (figure 9.10).

Principe des techniques itératives.

On ne peut pas simplement réaliser l'opération inverse de la projection, mais on peut projeter informatiquement l'image reconstruite, comme on peut projeter l'objet. La comparaison des projections permet de modifier l'image reconstruite pour la rendre plus proche de l'objet.

Dessin : Emmanuel Durand.

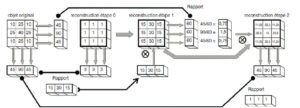

Le prototype de ce type d'algorithme itératif, ART (algebraic reconstruction technique), procède de la manière suivante : à partir d'une première coupe quelconque, l'algorithme ajuste étape par étape la coupe recherchée au moyen d'une rétroprojection normalisée par de l'écart entre les projections effectivement mesurées et celles déduites de la coupe en cours d'évaluation (figure 9.11).

Reconstruction itérative : exemple simplifié.

On part d'une image vierge (composée de 0) et on la projette verticalement. On compare cette projection (0 ; 0 ; 0) à la projection de l'objet dans la même direction (45 ; 90 ; 45). On en fait la différence qu'on normalise en divisant par 3 (car somme sur 3 pixels). On obtient (15 ; 30 ; 15) qu'on va rétroprojeter dans la même direction verticale et l'ajoutant à l'image de départ. On obtient alors la reconstruction à l'étape 1. On va maintenant faire une projection de cette nouvelle image reconstruite dans une autre direction, ici horizontale ; on obtient (60 ; 60 ; 60) qu'on va comparer à la projection de l'objet dans la même direction (45 ; 90 ; 45). On normalise la différence en divisant par 3 pour obtenir (–5 ; 10 ; –5). On rétroprojette cette projection horizontalement et on l'ajoute à l'image précédemment reconstruite. Dans cet exemple simple, la reconstruction permet de trouver l'objet qu'on a projeté dès la deuxième itération. En pratique, il faut généralement prendre davantage de projections pour obtenir une reconstruction correcte.

Dessin : Emmanuel Durand.

L'algorithme itératif qui s'est imposé depuis les années 2000 opère itérativement comme ART, mais la correction est cette fois multiplicative et l'écart est évalué par le rapport entre projections acquises et estimées.

Plus précisément, cet algorithme fonctionne en multipliant chaque valeur inconnue de pixel i par la moyenne pondérée (par les coefficient ri,j) des rapports entre les projections j acquises et estimées qui concernent ce pixel i (voir figure 12). Il porte le nom de MLEM (pour maximum likelihood-expectation-maximisation), d'OSEM dans sa version accélérée ou de MAP-OSEM dans sa version régularisée.

6.6.Le lecteur pourra reprendre l'exemple de la figure 9.12 en initialisant la matrice à l'étape 0 avec autre chose que des 1. Il pourra alors constater qu'on aboutit à une convergence de l'algorithme sur une solution différente. Par exemple, une initialisation avec :

conduirait en une seule itération à la solution :

Cela illustre le fait qu'il peut y avoir plusieurs solutions au problème lorsque le nombre de projections est insuffisant.

Algorithme itératif multiplicatif.

On part d'une image vierge composée de 1 qu'on projette dans une première direction (ici verticale) ; on compare la projection obtenue (3 ; 3 ; 3) avec la projection de l'objet dans la même direction (45 ; 90 ; 45). Le rapport (15 ; 30 ; 15) va être rétroprojeté dans la même direction (verticale) pour servir de facteur multiplicatif pour obtenir l'image reconstruite à l'étape 1. En partant de cette dernière image, on réalise une projection dans une autre direction et on continue sur le même principe. Dans cet exemple simple, la reconstruction permet d'atteindre une convergence dès la deuxième itération. Le résultat obtenu n'est pas tout à fait l'image de départ : en pratique, il faut généralement prendre davantage de projections pour obtenir une reconstruction correcte.

Dessin : Emmanuel Durand.

Essentiel à retenir

- Les images acquises en radiographie et en scintigraphie sont des images de projection.

- Reconstruire une image en coupe revient à résoudre un grand système mal conditionné d'équations linéaires.

- Les techniques de reconstruction incluent l'algorithme de rétroprojection filtrée (et autres techniques analytiques apparentées) et les techniques itératives (ou algébriques) parmi lesquelles MLEM et sa variante OSEM sont les plus utilisées.

- Les techniques itératives présentent divers avantages parmi lesquels la possibilité de reconstruire des coupes à partir de données de projection incomplètes, de diminuer l'irradiation du patient en TDM et de mieux corriger les artefacts d'atténuation en TEP et tomoscintigraphie.

- L'algorithme MLEM opère itérativement en multipliant chaque valeur de pixel j de la coupe par la moyenne pondérée (par les coefficient ri,j) des rapports entre les projections i acquises et estimées qui concernent ce pixel j.

Référence

[1] Mariano-Goulart D. Reconstruction tomographique en imagerie médicale. EMC (Elsevier Masson SAS, Paris), Radiodiagnostic - Principes et techniques d'imagerie. 35-105-A-10 ; 2015.

|

Chapitre suivant |

|

Retour au sommaire |

Les fondamentaux - Chapitre 8 - Imagerie par résonance magnétique

T. Tourdias et V. Lebon

Plan du chapitre

- Le phénomène de résonance magnétique nucléaire

- Principes de localisation du signal en IRM

- Les principales séquences d'IRM

- Agents de contraste en IRM

- Réalisation pratique d'un examen IRM

Objectifs

- Connaître les bases du phénomène de résonance magnétique nucléaire.

- Connaître les principes généraux permettant la localisation spatiale du signal en IRM.

- Connaître le principe général des principales séquences d'IRM.

- Connaître les règles d'utilisation des agents de contraste pour l'IRM.

- Savoir expliquer à un patient la conduite pratique d'un examen IRM.

Le phénomène de résonance magnétique nucléaire

Apparue à l'hôpital dans les années 1980, l'imagerie par résonance magnétique (IRM) exploite le phénomène de résonance magnétique nucléaire (RMN). Ce phénomène, qui met en jeu les particules élémentaires du noyau atomique, peut être décrit en toute rigueur par la mécanique quantique. Cependant, les phénomènes macroscopiques observés lors d'une expérience d'IRM peuvent être décrits à l'aide d'outils vectoriels plus simples. Cette description phénoménologique, qui repose sur un formalisme mathématique adapté au diplôme de formation générale en sciences médicales (DFGSM), sera utilisée dans ce chapitre.

Notions de source magnétique, de champ magnétique et d'aimantation

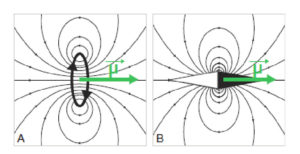

Une source magnétique est un système qui génère un champ magnétique , dont la valeur s'exprime en teslas (T). C'est par exemple une boucle de courant (courant électrique dans un circuit en forme de cercle : électro-aimant), ou bien une tige de métal aimantée comme l'aiguille d'une boussole (figure 8.1).

Exemples de sources magnétiques.

Une boucle de courant (A) ou une aiguille aimantée (B) génèrent un champ magnétique, représenté par les lignes de champ ; le moment magnétique µ est une représentation vectorielle de la source magnétique.

Cette source génère un champ magnétique, champ vectoriel qu'on peut représenter sous forme de lignes d'isochamp dans un plan particulier de l'espace. Une façon plus simple de représenter la source magnétique consiste à utiliser un vecteur, qu'on appelle « moment magnétique » et qu'on note . La norme du vecteur traduit l'intensité de la source magnétique et les coordonnées du vecteur traduisent l'orientation de cette source. La densité de moment magnétique (moment magnétique par unité de volume) est appelée « aimantation » et notée M.

Deux moments magnétiques interagissent entre eux via leurs champs magnétiques. Le champ magnétique B0 résultant d'un premier moment magnétique exerce un couple sur le second moment, c'est-à-dire qu'il tend à le faire tourner pour l'aligner dans la direction du champ magnétique (figure 8.2). La position d'équilibre d'une aimantation dans un champ magnétique est donc la position alignée par rapport à ce champ. C'est ainsi que le champ magnétique terrestre oriente l'aiguille des boussoles.

Interaction entre une aimantation μ et un champ magnétique statique B0: µ s'aligne parallèlement à B0.

Aimantation nucléaire

Les noyaux de certains atomes possèdent une aimantation intrinsèque. Par analogie avec la boucle de courant, on considère cette aimantation comme résultant du déplacement des particules élémentaires chargées qui tournent sur elles-mêmes ou en orbite. Le terme « spin » (qui signifie tourner en anglais) est parfois utilisé pour désigner l'aimantation d'une particule élémentaire qui tourne sur elle-même. En toute rigueur, le spin désigne un observable quantique dont la manipulation dépasse le cadre de cet ouvrage.

Les noyaux d'hydrogène – qui sont constitués d'un simple proton – font partie des noyaux possédant une aimantation intrinsèque. Ils présentent un intérêt majeur pour l'exploration du corps humain dans lequel l'hydrogène est très abondant, puisque les tissus biologiques sont principalement constitués d'eau et de triglycérides (graisse sous-cutanée et viscérale). L'IRM consiste à détecter l'aimantation des noyaux d'hydrogène et à la localiser pour reconstruire des images qui, en première approximation, sont des cartes de distribution de l'eau et de la graisse du corps humain.

Détecter les aimantations nucléaires n'a rien d'évident, pour deux raisons :

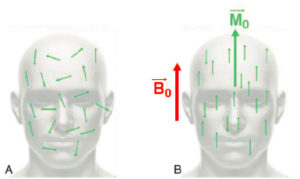

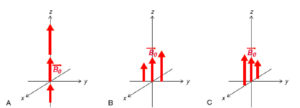

- en l'absence de champ magnétique, les aimantations microscopiques sont orientées aléatoirement (figure 8.3A), si bien que leur somme vectorielle est nulle. Cela reste vrai dans le champ magnétique terrestre dont l'intensité est trop faible pour modifier significativement l'orientation des aimantations microscopiques. Il faudra donc au préalable « polariser » ces aimantations, c'est-à-dire les orienter dans une direction privilégiée ;

- on ne sait détecter efficacement une aimantation peu intense (ce qui est le cas de l'aimantation nucléaire) qu'en la mettant en mouvement. Il faudra pour cela la mettre en résonance.

A, B. Polarisation des aimantations nucléaires.

En l'absence de champ magnétique, les aimantations des noyaux d'hydrogène sont orientées de manière aléatoire : leur somme vectorielle est nulle (A) ; en présence d'un champ B0, elles s'orientent le long du champ B0, en position parallèle ou antiparallèle. L'orientation parallèle étant majoritaire, il en résulte une aimantation macroscopique M0 parallèle à B0(B).

Les noyaux d'hydrogène sont donc porteurs d'une aimantation qui tend spontanément à s'aligner avec le champ magnétique B0.

Polarisation de l'aimantation par un champ magnétique B0

En présence d'un champ magnétique B0, les aimantations des noyaux d'hydrogène adoptent une orientation privilégiée. Par analogie avec les aimantations macroscopiques, on peut les représenter comme des vecteurs tendant à s'aligner parallèlement à B0. Mais, à l'échelle atomique, l'énergie d'interaction entre l'aimantation d'un noyau d'hydrogène et le champ B0 est quantifiée : elle ne peut prendre que deux valeurs discrètes. Cela implique que l'aimantation nucléaire ne peut adopter que deux orientations dans le champ magnétique B0: « parallèle » et « antiparallèle » (figure 8.3B). L'état parallèle est plus peuplé que l'état antiparallèle. Le surplus d'aimantations microscopiques orientées dans la même direction que B0 donne naissance à une aimantation nucléaire macroscopique M0.

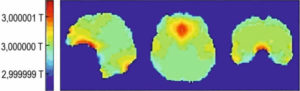

M0 est reliée à B0 par la relation : M0 = x * B0. Le coefficient de proportionnalité χ est la susceptibilité magnétique qui caractérise la capacité d'un milieu de s'aimanter sous l'effet d'un champ magnétique externe. Dans un milieu homogène infini de susceptibilité χ, si l'on applique un champ magnétique B0, le milieu va s'aimanter et le champ magnétique résultant sera (1 + χ).. Selon le cas, on peut avoir :

- χ < 0 : le champ magnétique est diminué en présence du matériau qui est dit « diamagnétique » ;

- χ > 0 de faible valeur : le champ magnétique est renforcé en présence du matériau qui est dit paramagnétique ;

- χ > 0 de forte valeur : le champ magnétique est très renforcé en présence du matériau qui est dit ferromagnétique.

Une fois l'aimantation macroscopique M0 créée, il faut la mettre en mouvement pour la détecter.

Dans un fort champ magnétique, les aimantations des noyaux d'hydrogène s'alignent entre elles. La résultante est une aimantation globale de la matière alignée sur B0 qui va être à l'origine du phénomène de RMN.

Mise en résonance de l'aimantation par une excitation radiofréquence

En physique, la résonance désigne un phénomène physique qui permet de transférer de l'énergie à un système par un phénomène oscillatoire. Le transfert d'énergie n'est possible que s'il s'effectue à une fréquence propre au système dite fréquence de résonance. Si on soumet un système résonant à une excitation ponctuelle (impulsion), alors le système sera le siège d'oscillations amorties, sur une fréquence proche de sa fréquence propre, et retournera progressivement à son état stable. Ce phénomène existe dans de très nombreux domaines de la physique : en acoustique, en électricité ou en mécanique.

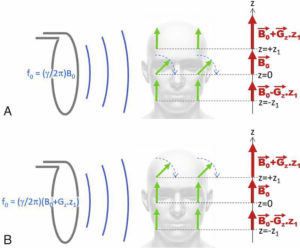

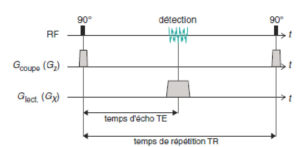

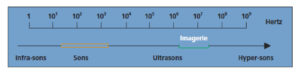

C'est ce principe de résonance qu'on utilise pour mettre en mouvement l'aimantation macroscopique M0. Pour transférer de l'énergie à une aimantation placée dans un champ magnétique B0, il faut lui appliquer une onde électromagnétique dont la fréquence f0 est donnée par la relation de Larmor : f0 = γ/(2π). La fréquence propre de l'aimantation f0 est appelée fréquence de Larmor. La constante γ est appelée rapport gyromagnétique. C'est une constante caractéristique de chaque noyau possédant une aimantation. Pour le noyau d'hydrogène, γ/(2π) = 42,57 mégahertz par tesla (MHz/T). Pour les champs magnétiques utilisés en IRM, l'ordre de grandeur de f0 est 100 MHz, ce qui correspond aux fréquences de la bande FM, d'où l'appellation « ondes radiofréquence » (RF). L'émetteur utilisé en IRM fonctionne selon les mêmes principes qu'un émetteur radio. Il s'agit d'une antenne d'émission de forme généralement cylindrique qui est intégrée dans le tunnel de l'IRM.

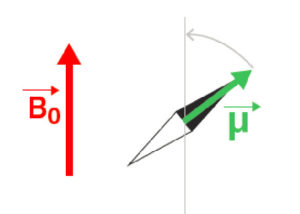

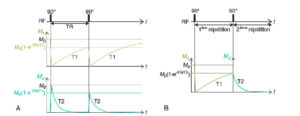

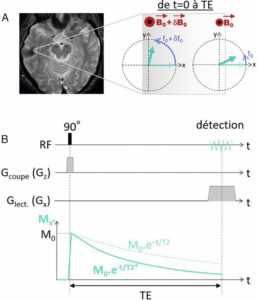

L'énergie transférée par l'onde RF se traduit par le basculement de l'aimantation qui s'écarte de sa position d'équilibre le long de B0 (figure 8.4A). Cela correspond à l'excitation radiofréquence. Pour décrire l'évolution temporelle de l'aimantation, on se place dans un repère (O,x,y,z) centré sur l'aimantation, dont la direction z est celle du champ magnétique B0 (direction du tunnel de l'IRM), qui est également la direction de l'aimantation à l'équilibre M0. On désigne z comme la direction longitudinale et le plan (x, y) comme le plan transverse. Le vecteur aimantation M peut se décomposer en une composante longitudinale (dont la projection sur z vaut Mz) et une composante transversale de norme Mxy (figure 8.4B). Ainsi, lorsque l'aimantation est à l'équilibre avec B0, à distance de toute excitation RF, on a : Mz = M0 et Mxy = 0. Juste après une excitation basculant l'aimantation de 90°, on a : Mz = 0 et Mxy = M0.

Excitation radiofréquence.

L'application d'une onde électromagnétique à la fréquence de Larmor f0 bascule l'aimantation vers le plan transverse (A) ; l'aimantation écartée de sa position d'équilibre peut être décrite par ses composantes transversale Mxy et longitudinale Mz (B).

L'excitation RF peut être caractérisée par l'angle dont l'aimantation bascule, qui est proportionnel à la durée d'application de l'onde RF et à l'intensité de cette onde. L'angle de bascule peut donc être choisi librement en jouant sur ces deux paramètres. En IRM, on utilise des émissions très courtes, de l'ordre de la milliseconde : on parle d'impulsions radiofréquences.

Sous l'influence d'une onde radio à une fréquence caractéristique (fréquence de Larmor), l'aimantation des noyaux d'hydrogène pivote et se retrouve perpendiculaire à B0. Initialement portée par l'axe longitudinal (parallèle à B0), l'aimantation se retrouve donc dans le plan transversal (perpendiculaire à B0)

Retour à l'équilibre de l'aimantation

Suite à l'impulsion RF, l'aimantation retourne à sa position d'équilibre le long de z, de la même manière que l'aiguille d'une boussole s'aligne sur le champ magnétique terrestre. Toutefois, le retour à l'équilibre de l'aimantation ne s'effectue pas selon une rotation vers l'axe z, mais selon une dynamique complexe combinant trois processus :

- la rotation de M autour de la direction de B0 (axe z) à la fréquence de Larmor f0 (figure 8.5A). Ce mouvement de rotation est désigné par le terme de précession libre, parce qu'il s'effectue en l'absence de toute excitation RF. Il faut noter que la précession s'effectue à une vitesse remarquablement élevée : dans un champ magnétique de 1,5 tesla, f0 vaut 63,9 MHz, ce qui signifie que M effectue 63 900 000 tours en une seconde. Ce mouvement de rotation correspond au signal d'IRM ;

Retour à l'équilibre.

Après l'excitation RF, l'aimantation retourne à sa position d'équilibre selon un mouvement combinant une précession autour de l'axe z à la fréquence f0 (A), une décroissance exponentielle en T2 de la composante transversale Mxy et une récupération exponentielle en T1 de la composante longitudinale Mz ; la trajectoire parcourue par l'extrémité du vecteur M dessine une forme de « chapeau pointu » (B).

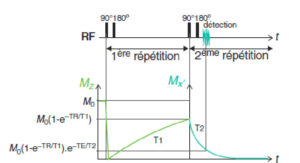

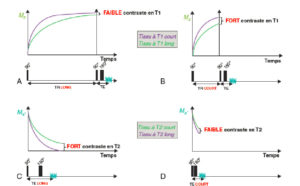

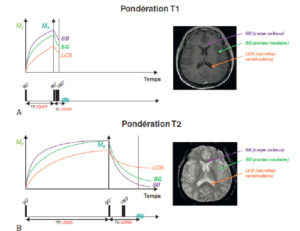

- la disparition de la composante transversale Mxy qu'on appelle la relaxation transversale : dès la fin de l'excitation RF, l'intensité de l'aimantation transversale décroît selon un processus exponentiel caractérisé par la constante de temps T2, décrit par l'équation : dMxy/dt = –1/T2 Mxy(t). Pour une impulsion RF de 90°, cette équation admet pour solution : Mxy(t) = M0 exp(–t/T2). La constante T2 est le temps de relaxation transversale. Il caractérise la persistance transversale de l'aimantation. Dans les tissus mous, le T2 de l'eau est de l'ordre de 0,1 seconde. Cette relaxation transversale correspond à l'épuisement du signal IRM ;

- la récupération de la composante longitudinale qu'on appelle la relaxation longitudinale : dès la fin de l'excitation RF, l'intensité de l'aimantation longitudinale croît selon un processus exponentiel caractérisé par la constante de temps T1, décrit par l'équation : dMz/dt = 1/T1 [M0–Mz(t)]. Pour une impulsion RF de 90°, cette équation admet pour solution : Mz(t) = M0.[1-exp(–t/T1)]. La constante T1 est le temps de relaxation longitudinale. Il caractérise la vitesse à laquelle l'aimantation retourne à sa valeur d'équilibre M0. Dans les tissus mous, T1 est de l'ordre de 1 seconde (aux valeurs de B0 utilisées pour l'IRM). Cette relaxation longitudinale correspond à la régénération de la réserve de signal.